🚀 Deep Learning desde cero… ¡y sin TensorFlow ni PyTorch!#

Este enfoque propone construir redes neuronales profundas usando solo Numpy, con una arquitectura más explicable, rápida, robusta y fácil de ajustar.

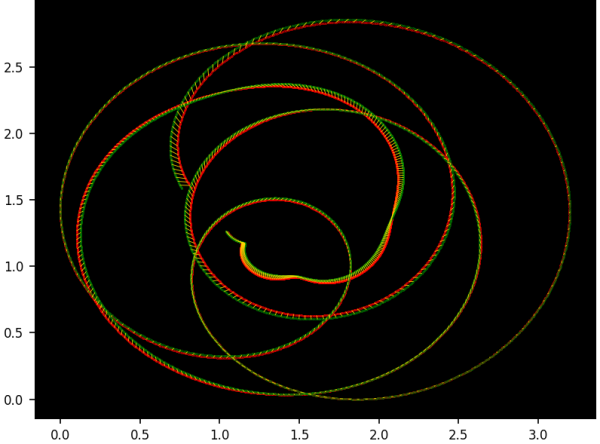

Lo más innovador: técnicas como equalization, chaotic gradient descent y ghost parameters para acelerar y estabilizar el entrenamiento.

🔟 10 Key Features para potenciar DNN#

- 🔁 Reparameterization — Cambiar la forma de los parámetros para mejorar estabilidad o flexibilidad.

- 👻 Ghost parameters — Parámetros “fantasma” que suavizan el descenso y permiten watermarking.

- 🧱 Layer flattening — Optimizar todas las capas a la vez, reduciendo propagación de errores.

- 🪜 Sub-layers — Optimizar por bloques de parámetros, útil en alta dimensión.

- 🐝 Swarm optimization — Múltiples partículas explorando el espacio para evitar mínimos locales.

- 🔥 Decaying entropy — Permitir ascensos controlados para escapar de trampas del gradiente.

- 🎚️ Adaptive loss — La función de pérdida cambia dinámicamente para reactivar el aprendizaje.

- ⚖️ Equalization — Transformar temporalmente la salida para acelerar la convergencia.

- 📏 Normalized parameters — Todo en [0,1] para evitar explosiones del gradiente.

- 🧮 Math-free gradient — Gradientes sin fórmulas: solo datos y tablas precomputadas.

🧠 Explicación en pocas palabras#

Si eres nuevo en esto, imagina que una red neuronal es una máquina que aprende patrones.

Este enfoque propone:

- Usar funciones no lineales simples en lugar de capas tradicionales.

- Añadir “trucos” que ayudan al modelo a aprender más rápido y evitar bloqueos.

- Transformar temporalmente la salida para que el aprendizaje sea más eficiente.

- Mantener el código mínimo y transparente, sin frameworks pesados.

El resultado: modelos más rápidos, más explicables y más fáciles de ajustar.

Más información en el link 👇

También publicado en LinkedIn.