🎯 Probabilidad Condicional: la base silenciosa del Machine Learning

En ML, casi todo se reduce a una idea clave: calcular la probabilidad de algo dado que otra cosa ocurre.

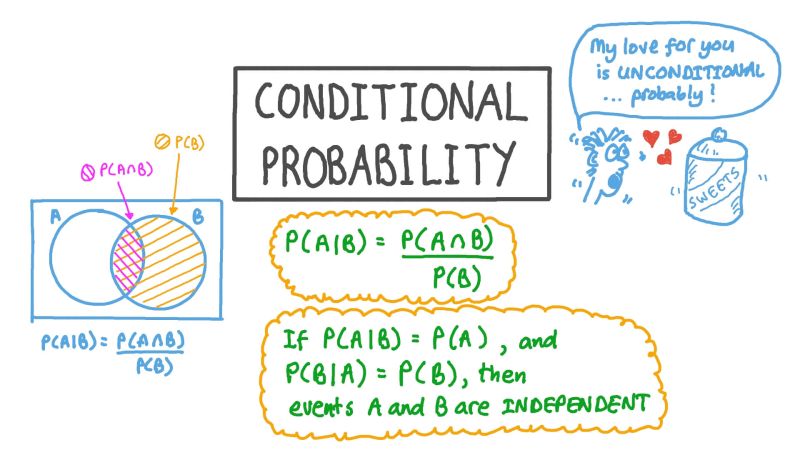

Eso es la probabilidad condicional 👉 $P(A|B)$.

📩 Ejemplo simple: detección de spam

Queremos saber: si un email contiene “free”, cuál es la probabilidad de que sea spam.

Para eso necesitamos entender:

- 📊 $P(Spam)$: cuántos correos suelen ser spam

- 🔍 $P(“free”)$: cuántos correos contienen “free”

- 🎯 $P(“free” | Spam)$: cuántos correos spam incluyen “free”

Este último es el que realmente impulsa modelos como Naive Bayes.

🤖 ¿Por qué importa?

- Porque todos los clasificadores hacen esto:

- $Recomendadores → ( P(\text{te gusta un ítem} | tu\ historial) )$

- $Diagnóstico médico → ( P(\text{enfermedad} | síntomas) )$

🧠 Piensa en esto como preguntar: “Dado lo que ya sé, qué tan probable es que ocurra X?”

Esa pregunta es el corazón de cómo las máquinas toman decisiones.

También publicado en LinkedIn.